0、相关资源

链接:https://pan.baidu.com/s/1dIULdpPpWghpGu7lUYLY9Q

提取码:

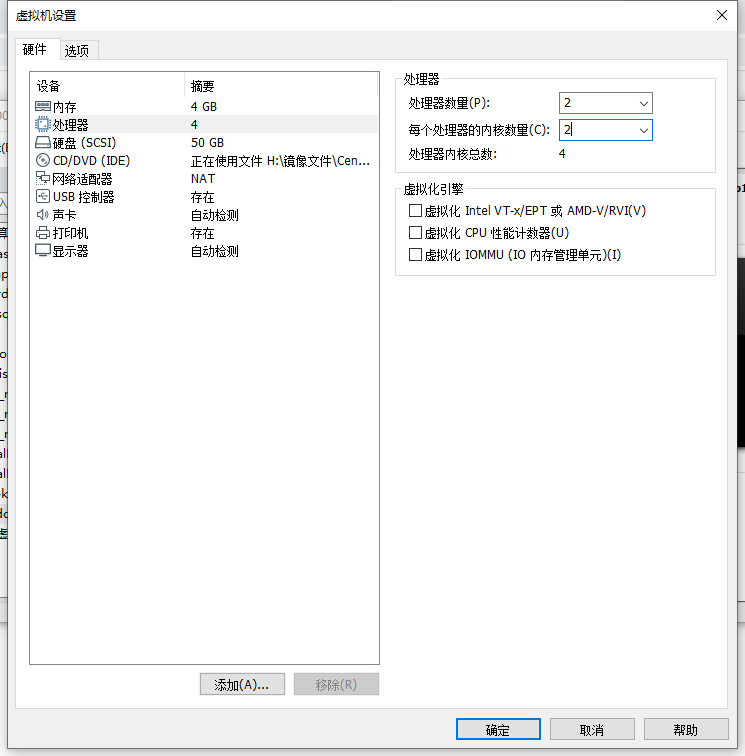

1、首先准备安装vm,安装一个centos的虚拟机

配置的参数如下:

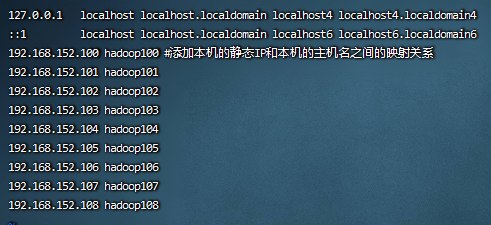

2、配置ip地址和主机名称,将虚拟机的ip地址固定还有主机的名称,参考vm虚拟机centos7设置固定IP

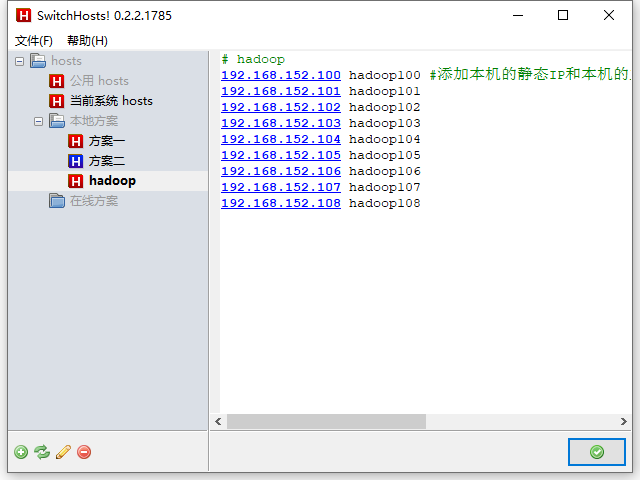

主机映射配置:

192.168.152.100 hadoop100#添加本机的静态IP和本机的主机名之间的映射关系

192.168.152.101 hadoop101

192.168.152.102 hadoop102

192.168.152.103 hadoop103

192.168.152.104 hadoop104

192.168.152.105 hadoop105

192.168.152.106 hadoop106

192.168.152.107 hadoop107

192.168.152.108 hadoop108

如图:

注意配置完以后要ping www.baidu.com 看能否链接外网

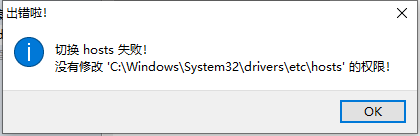

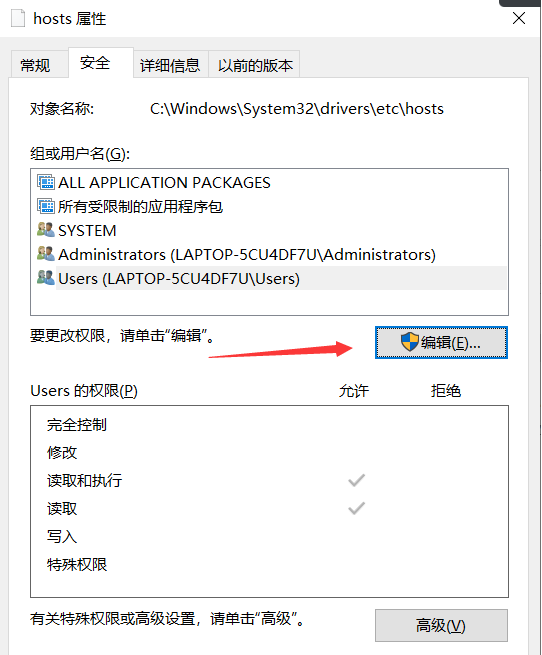

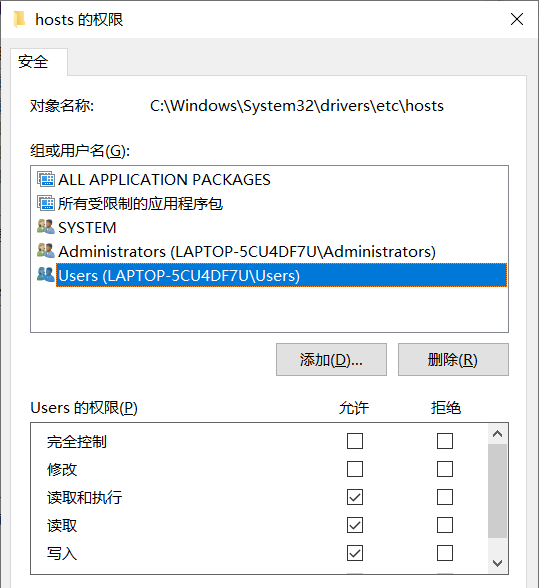

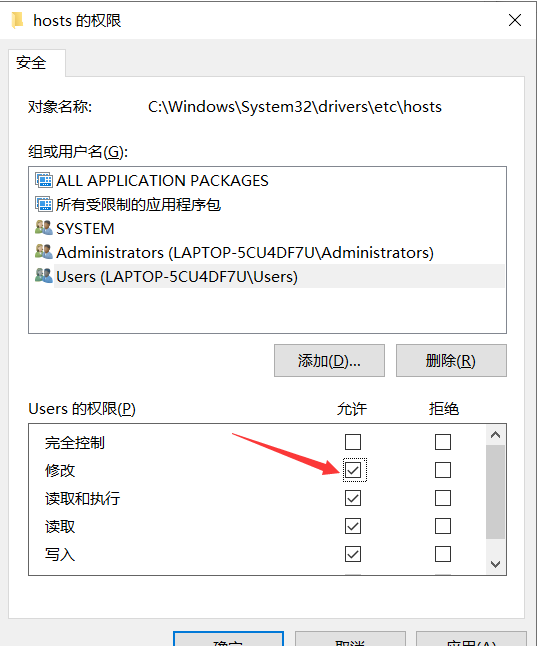

3、修改本机电脑的hosts文件

一般在这个目录下:C:\Windows\System32\drivers\etc

添加刚刚的配置

192.168.152.100 hadoop100#添加本机的静态IP和本机的主机名之间的映射关系

192.168.152.101 hadoop101

192.168.152.102 hadoop102

192.168.152.103 hadoop103

192.168.152.104 hadoop104

192.168.152.105 hadoop105

192.168.152.106 hadoop106

192.168.152.107 hadoop107

192.168.152.108 hadoop108

可以使用swithchosts工具进行修改(注意使用管理员的权限启动)

如出现

修改hosts一些权限属性,如下:

然后就能够修改了

4、安装相关的软件以及关闭防火墙

yum install -y epel-release

yum install -y net-tools 工具包集合

yum install -y vim 编辑器

systemctl stop firewalld.service 关闭防火墙

systemctl disable firewalld.service 开机关闭

5、添加一个用户

useradd haijin

passwd haijin

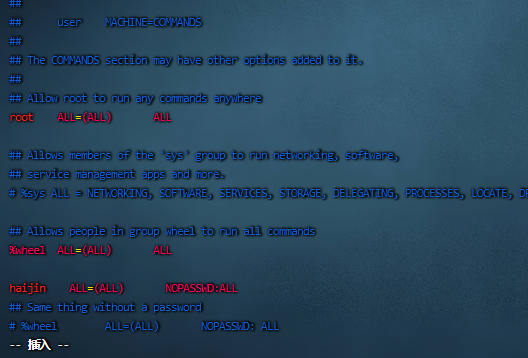

给haijin用户添加权限:

编辑:vim /etc/sudoers

haijin ALL=(ALL) NOPASSWD:ALL

注意:haijin这一行不要直接放到root行下面,因为所有用户都属于wheel组,你先配置了haijin具有免密功能,但是程序执行到%wheel行时,该功能又被覆盖回需要密码。所以haijin要放到%wheel这行下面。

切换为haijin用户:su haijin

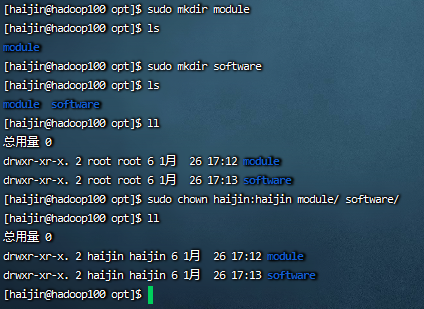

在/opt目录中创建几个文件夹

sudo mkdir module

sudo mkdir software

更改所有者:

sudo chown haijin:haijin module/ software/

如图:

卸载jdk

[root@hadoop100 ~]# rpm -qa | grep -i java | xargs -n1 rpm -e --nodeps

- rpm -qa:查询所安装的所有rpm软件包

- grep -i:忽略大小写

- xargs -n1:表示每次只传递一个参数

- rpm -e –nodeps:强制卸载软件

然后reboot重启虚拟机

6、克隆三台虚拟机

利用模板机hadoop100,克隆三台虚拟机:hadoop102 hadoop103 hadoop104

注意:克隆时,要先关闭hadoop100

修改对应的ip和主机名:

192.168.152.102 hadoop102

192.168.152.103 hadoop103

192.168.152.104 hadoop104

7、安装jdk

将jdk和hadoop等jar包放到/opt/software目录中

tar -zxvf jdk-8u212-linux-x64.tar.gz -C /opt/module/ 将jdk解压到/opt/module 目录中

使用命令:sudo vim /etc/profile.d/my_env.sh

添加如下配置:

#JAVA_HOME

export JAVA_HOME=/opt/module/jdk1.8.0_212

export PATH=$PATH:$JAVA_HOME/bin

让环境生效:source /etc/profile

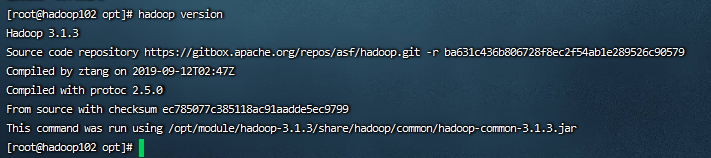

8、安装Hadoop

tar -zxvf hadoop-3.1.3.tar.gz -C /opt/module/ 将hadoop解压到/opt/module 目录中

使用命令:sudo vim /etc/profile.d/my_env.sh

添加如下配置:

#HADOOP_HOME

export HADOOP_HOME=/opt/module/hadoop-3.1.3

export PATH=$PATH:$HADOOP_HOME/bin

export PATH=$PATH:$HADOOP_HOME/sbin

让环境生效:source /etc/profile

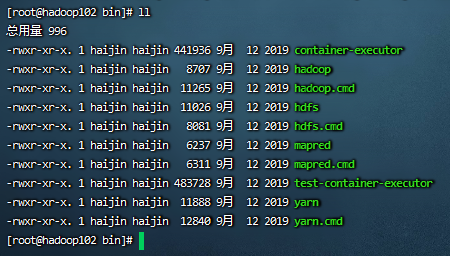

1)bin目录:存放对Hadoop相关服务(hdfs,yarn,mapred)进行操作的脚本

(2)etc目录:Hadoop的配置文件目录,存放Hadoop的配置文件

(3)lib目录:存放Hadoop的本地库(对数据进行压缩解压缩功能)

(4)sbin目录:存放启动或停止Hadoop相关服务的脚本

(5)share目录:存放Hadoop的依赖jar包、文档、和官方案例

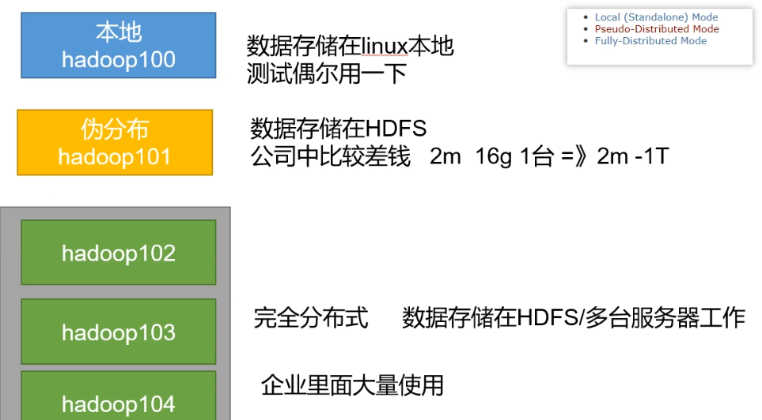

9、Hadoop运行模式

Hadoop官方网站:http://hadoop.apache.org/

Hadoop运行模式包括:本地模式、伪分布式模式以及完全分布式模式。

- 本地模式:单机运行,只是用来演示一下官方案例。生产环境不用。

- 伪分布式模式:也是单机运行,但是具备Hadoop集群的所有功能,一台服务器模拟一个分布式的环境。个别缺钱的公司用来测试,生产环境不用。

- 完全分布式模式:多台服务器组成分布式环境。生产环境使用。

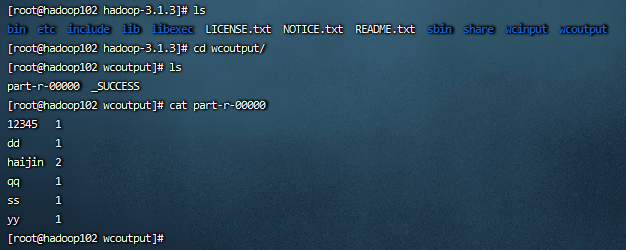

10、基本测试:

mkdir /opt/module/hadoop-3.1.3/wcinput 创建一个文件夹

在wcinput中vim word.txt

输入:

haijin

12345

ss

yy

qq

dd

haijin

在hadoop目录下输入:bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-3.1.3.jar wordcount wcinput/ wcoutput/

然后hadoop就会进行计算,我们可以在wcoutput/下查看计算后的结果(注意输出的wcoutput/不能存在)

如图:

这样我们hadoop的本地搭建就已经完成了,下次我们再来进行完全分布式的安装。