lxml:是使用c语言开发一个性能比较高的html解析库

xpath:是一门在XML文档中查找信息的语言

xpath相关概念:

父(parent)

子 (Children)

同胞 (Sibling)

先辈 (Ancestor)

后代 (Descendant)

| 表达式 | 描述 |

|---|---|

| nodename | 选取此节点的所有子节点 |

| // | 从任意子节点中选取 |

| / | 从根节点选取 |

| . | 选取当前节点 |

| .. | 选取当前节点的父节点 |

| @ | 选取属性 |

| 解析器 | 速度 | 难度 |

|---|---|---|

| re | 最快 | 难 |

| BeautifulSoup | 慢 | 非常简单 |

| lxml | 快 | 简单 |

下面我们就来进行使用一个案例,如下:

from lxml import etree

import requests

html_doc = """

<html><head><title>The Dormouse's story</title></head>

<body>

<p class="title"><b>The Dormouse's story</b></p>

<p class="story">Once upon a time there were three little sisters; and their names were

<a href="http://example.com/elsie" class="sister" id="link1">Elsie</a>,

<a href="http://example.com/lacie" class="sister" id="link2">Lacie</a> and

<a href="http://example.com/tillie" class="sister" id="link3">Tillie</a>;

and they lived at the bottom of a well.</p>

<p class="story">...</p>

"""

selector = etree.HTML(html_doc)

# 取出页面内所有的链接

links = selector.xpath('//p[@class="story"]/a/@href')

for link in links:

print(link)

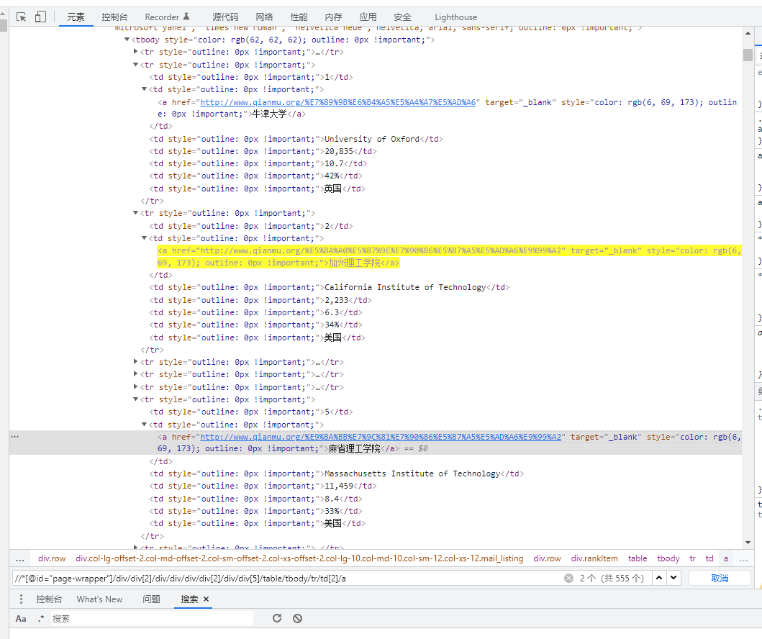

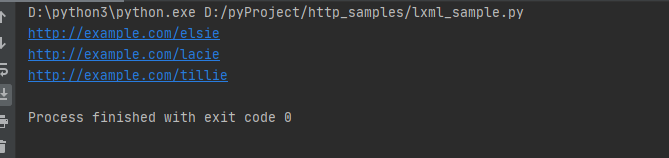

如图:

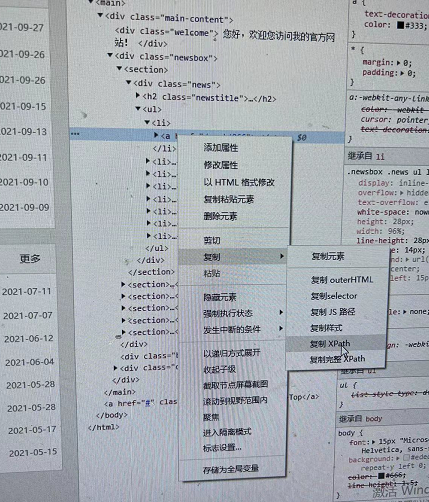

选择需要爬取的网页数据,然后进行复制xpath,如图:

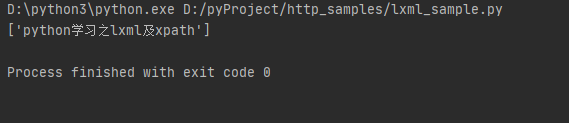

相关代码如下:

r = requests.get('https://www.haijin.xyz/')

se = etree.HTML(r.text)

print(se.xpath('/html/body/main/div/div[2]/section[1]/div/ul/li[1]/a/text()'))

如图:

2022-02-20:

在浏览器中可通过Ctrl+F搜索输入xpath即可搜索你想要搜索的元素,如图: