1、先查看上一篇文章: Hadoop学习之Hadoop伪分布式安装

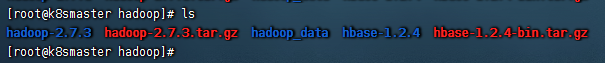

2、解压tar -zxvf hbase-1.2.4-bin.tar.gz ,如图:

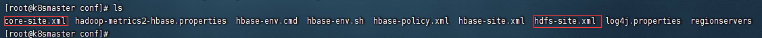

3、将Hadoop安装的相关配置复制到hbase的conf目录下

cp /usr/local/hadoop/hadoop-2.7.3/etc/hadoop/hdfs-site.xml .

cp /usr/local/hadoop/hadoop-2.7.3/etc/hadoop/core-site.xml .

如图:

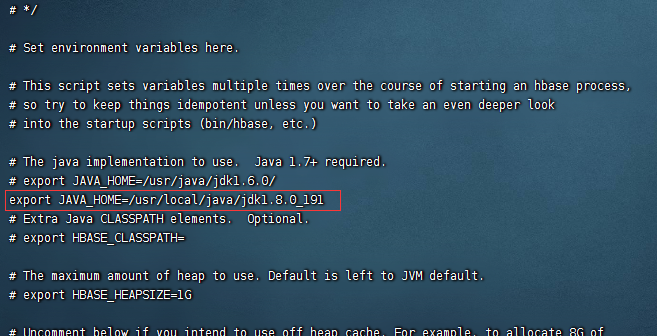

4、配置Hbase的相关配置: vi hbase-env.sh

首先配置jdk:export JAVA_HOME=/usr/local/java/jdk1.8.0_191

如图:

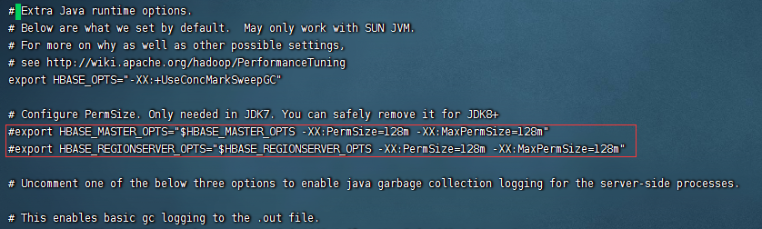

因为我们配置的jdk是1.8,所以我们需要将其中的两行注释调:

export HBASE_MASTER_OPTS="$HBASE_MASTER_OPTS -XX:PermSize=128m -XX:MaxPermSize=128m"

export HBASE_REGIONSERVER_OPTS="$HBASE_REGIONSERVER_OPTS -XX:PermSize=128m -XX:MaxPermSize=128m"

如图:

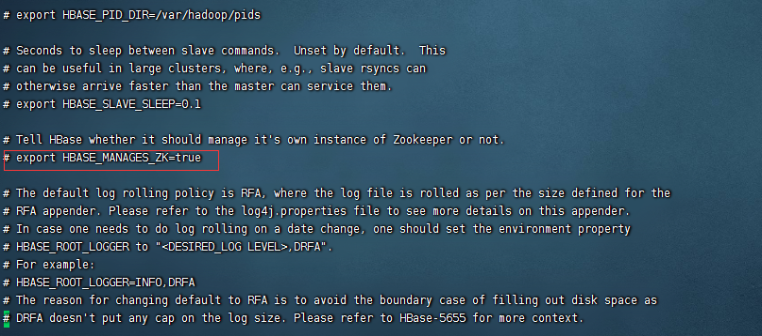

Shift+G 跳到文件的末尾,如图:

这个我们就使用Hbase的默认zookeeper,不做更改了

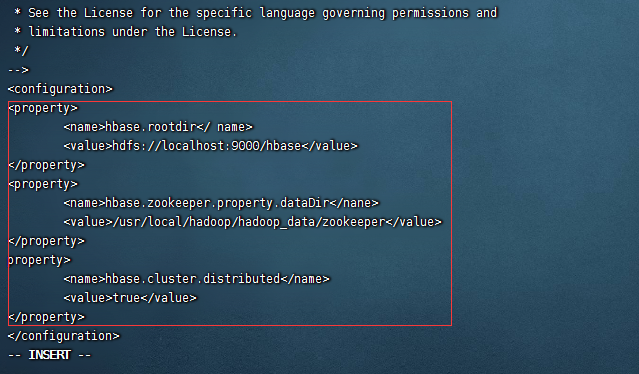

5、然后我们来配置vi hbase-site.xml

<property>

<name>hbase.rootdir</name>

<value>hdfs://localhost:9000/hbase</value>

</property>

<property>

<name>hbase.zookeeper.property.dataDir</name>

<value>/usr/local/hadoop/hadoop_data/zookeeper</value>

</property>

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

配置说明:

第一个配置指的是hbase在hdfs的根目录在哪里

第二个配置指的是hbase自带的zookeeper数据目录在哪里

第三个配置指的是是否使用集群的方式去运行

如图:

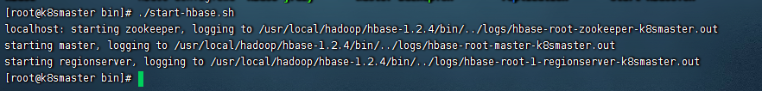

6、启动,我们进入hbase目录下的bin下:

./start-hbase.sh

如图:

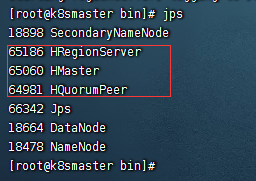

输入jps

如图:

这三个就是Hbase的进程

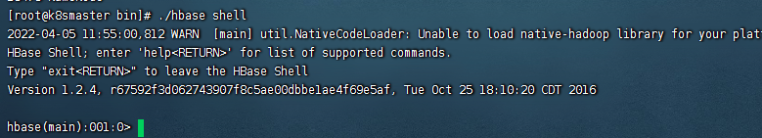

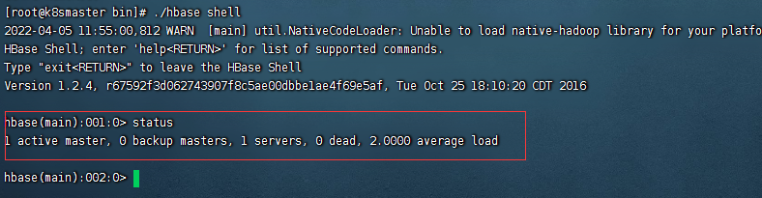

7、然后我们检测一个Hbase是否正常运行:

./hbase shell

如图:

输入:status

如图:

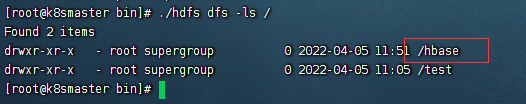

8、检测Hdfs中是否有创建目录:

cd /usr/local/hadoop/hadoop-2.7.3/bin

输入:./hdfs dfs -ls /

如图:

如此就表示已经自动创建了目录